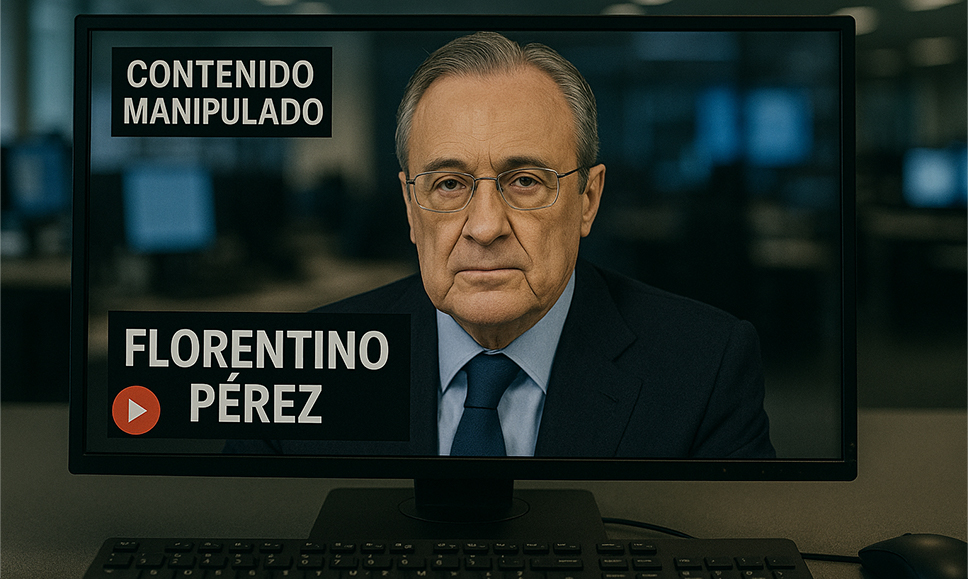

Circula un video falso de Florentino Pérez realizado con IA en donde promociona la plataforma de inversión Infinity Bitwave, que no está habilitada en España. Las víctimas de la estafa son empujadas a depositar sumas cada vez mayores y a entregar información personal. Siguen acumulándose casos de deepfakes.

La imagen de Florentino Pérez Rodríguez fue usada sin su consentimiento.

Estafadores usan la imagen de Florentino Pérez

Una nueva estafa recorre la web. Se trata de contenidos donde supuestamente se ve a Florentino Pérez, presidente del Real Madrid, recomendando una plataforma de inversión con el nombre de Infinity Bitwave. Pero no es real, sino un mero señuelo creado con inteligencia artificial.

A esto se lo llama deepfake e implica la adulteración de la voz y la imagen de una persona para manipular a la audiencia. En este caso, se lo puede ver a Florentino Pérez recomendando una inversión de 250€ con la que “se asegurará un futuro financiero para usted y sus hijos”.

La imagen de una figura conocida como Florentino Pérez genera confianza en el público, pero el caso es que la publicidad tenía como destino una plataforma de inversión que no figura en el listado de operadores habilitados en la Comisión Nacional de Mercado de Valores (CNMV).

En efecto, Inifinity Bitwave reúne todos los requisitos para ser considerado un fraude: utiliza la imagen de una personalidad pública sin su consentimiento, sumerge a las víctimas en una red de inversiones sin sustento, y se vale de la información personal de los usuarios para profundizar la estafa.

Cómo funciona la estafa con el vídeo de Florentino Pérez

El vídeo de Florentino Pérez es el primer paso para que las víctimas tomen confianza y soliciten más información a través de un formulario. Hecho esto, comienzan los contactos con los aparentes asesores. Para ingresar en la red se requiere un depósito de 250€ y varias pruebas de seguridad.

Estas pruebas implican el envío de la foto del DNI, la validación del rostro mediante videollamada y otros pasos que, indefectiblemente, implican compartir información sensible. Si se tratara de una entidad regulada, habría garantías de que los datos permanecerían protegidos. En esto caso, sin embargo, es todo lo contrario.

Porque los estafadores utilizan la información personal para seguir ahondando en el fraude. Con el registro de la voz y la imagen de la víctima, pueden abrir cuentas a su nombre, solicitar créditos y generar otros problemas.

Pero volviendo al sistema de inversión: luego del depósito inicial, la plataforma se gana la confianza de los estafados enviándoles pequeñas sumas de dinero a sus cuentas bancarias. Esto es, en teoría, para verificar que los retiros funcionen correctamente.

Cuando la persona ya confía, se le piden depósitos mayores para seguir avanzando. Los casos hablan de sumas de entre 1.000€ y 5.000€. Claramente este es el objetivo de los delincuentes, y una vez que se recibe el dinero, pueden cortar la conexión con la víctima.

No es el único caso: otras estafas con IA

El vídeo de Florentino Pérez es solo un ejemplo entre muchos. Sin ir más lejos, al propio presidente de España ha sufrido este mismo mecanismo de suplantación de la identidad mediante deepfakes. Fue con un vídeo en el que se veía a Pedro Sánchez promocionar inversiones en el sector energético mediante plataformas que, se supo después, no estaban reguladas.

La imitación de Sánchez fue una de las estafas con IA que toman una imagen real para replicarla. Otro ejemplo se dio con Elon Musk, en su caso con una red fraudulenta que ofrecía criptomonedas de regalo. En ambos casos, el engaño se usaba para robar los depósitos de los estafados.

Esta clonación de voz e imagen también afectó a la presidenta del Banco Santander, Ana Botín e incluso por el futbolista Lamine Yamal. Entonces, ante esta oleada de falsificaciones, lo principal antes de tomar la decisión de invertir es corroborar la habilitación de la plataforma en la CNMV. Que ninguna celebrity real o ficticia reemplace los verdaderos protocolos de seguridad.