El ChatGPT ha inspirado herramientas con la misma tecnología que se dedican a específicamente a la creación de phishing, malaware y deep fakes, entre otros. Se venden en la dark web y representan serios peligros a la integridad personal en internet. La inteligencia artificial lleva las estafas a una nueva sofisticación.

FraudGTP y WormGPT son algunos de los programas maliciosos con IA.

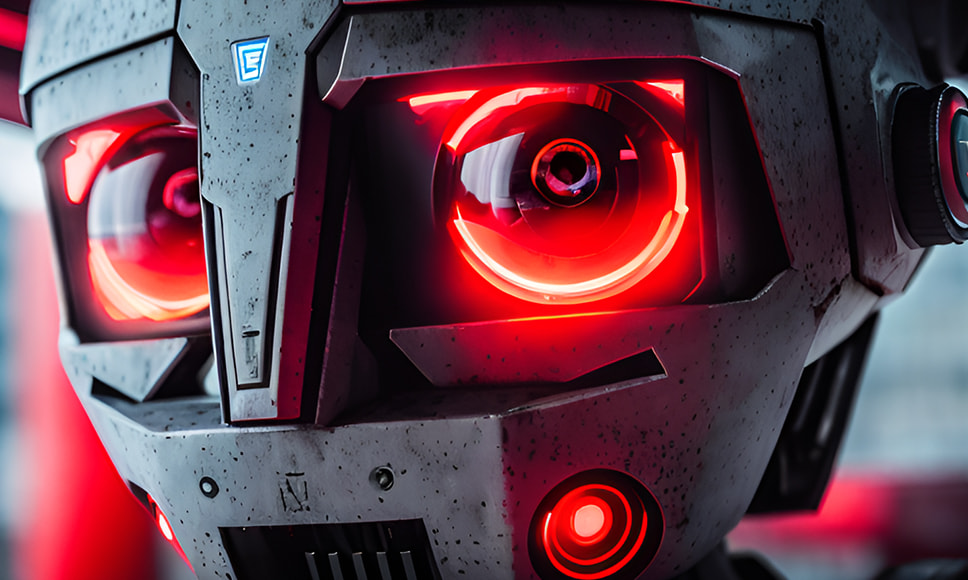

El fraude en tiempos de la inteligencia artificial

Los avances tecnológicos suelen acarrear peligros, y en el plano de la informática esto no es ninguna novedad. Lejos aún de un escenario apocalíptico digno de Terminator, la inteligencia artificial es una de las principales herramientas de los embaucadores digitales.

El éxito del ChatGPT suscitó todo tipo de réplicas maliciosas. El software basado en aprendizaje profundo permite crear texto de todo tipo, pero está configurado para no permitir la producción de malware. Un mecanismo que ha probado ser, a grandes rasgos, efectivo.

Es cierto que en algunas ocasiones se ha logrado conseguir que el ChatGPT se equivocara y creara diferentes tipos de software dañinos. Sin embargo, la principal arma para los estafadores ha sido la tecnología misma del chat, que puede ser replicada para generar instrumentos específicos para el fraude.

FraudGPT y WormGPT, los primos malignos del ChatGPT

En la dark web se pueden encontrar apps de inteligencia artificial orientadas a la estafa. Durante el año pasado, los medios y los especialistas prevenían contra el WormGPT, un software con las mismas características del ChatGPT, pero configurado para redactar malware, cadenas de mail falsas y anuncios espurios.

Este año se han encendido las alarmas por el FraudGPT, un tecnología similar, especializada en armar campañas de phishing y crear virus con un alto nivel de sofisticación. Los expertos siguen investigando para buscar modos de impedir su difusión.

Estos sistemas puede generar noticias falsas que se propagan a gran velocidad, lo cual se traduce en un aumento de la capacidad de falsificación de la realidad y del dominio de la opinión pública. Incluso podría crear trampas para el periodismo a gran escala.

Con estas herramientas se pueden producir cadenas de correo electrónico perfectamente escritas en diferentes lenguas. Esto podría ser usada para atacar empresas, entidades estatales y todo tipo de organizaciones.

En cuanto a la generación de malware, la inteligencia artificial generativa es un recurso idóneo para llevar la estafa a un nuevo nivel. La tecnología permite detectar falencias en sistemas de seguridad para causar daños. Así y todo, no existen virus por completo creados con IA.

La inteligencia artificial usada en estafas en casinos

El aprendizaje profundo también se ha utilizado para generar estafas en casinos online. Existen mecanismos que permiten crear bots en juegos como el póker, con los que se consigue que los usuarios pierdan todo lo que apuestan.

Esto ha llevado a miles de denuncias en todo el mundo, en tanto que se transmite el reclamo para que las herramientas de ciberseguridad estén a la altura de los delitos. La industria del juego invierto fuertemente en sistemas que brinden confianza a los jugadores.

Por ejemplo, la plataforma 888poker ha decidido recientemente reembolsar la suma de US$362.893 a más de 4.000 clientes que fueron estafados a través de bots. Entretanto, la firma articula nuevos sistemas de detección.

De hecho, 888poker lleva gastados más de US$1,2 millones en los últimos 3 años por hechos similares. El póker es particularmente susceptible a estas estafas que normalizamos cada vez más, puesto que no se trata de un juego de azar sino de un deporte mental en el que la destreza de los jugadores es determinante.

Pornografía y armas químicas: más amenazas de la IA

Otros usos que se le ha dado a la inteligencia artificial generativa es la creación de contenido íntimo no autorizado. Esto equivale a la producción de fotos o video pornográfico utilizando el rostro o el cuerpo de personas reales.

El caso más famoso es el de Taylor Swift, la cantante de Pensilvania, EE.UU. Circularon imágenes falsas de ella que generaron una gran polémica. Tanto fue así que ya hay un proyecto de ley en el Senado estadounidense para criminalizar la difusión de contenidos pornográficos con esta modalidad.

Los riesgos no terminan ahí. La inteligencia artificial ha logrado perfeccionar la estafa llamada pig-butchering, que consiste en generar una amistad con la víctima hasta que se logre entrar en confianza. El paso decisivo suele ser una inversión en criptomonedas que conduce a resultados invariablemente catastróficos.

Las apps especializadas logran ablandar a los blancos de la estafa al tratarlos de manera personalizada y compartiendo temas de interés puntual. Con la IA se puede confiar en una conexión mucho más exitosa que con personas reales.

Y aún queda algo reservado para el futuro: estos sistemas se podrían usar para fórmulas de armas bioquímicas. Aquí yacen peligros para la seguridad global, así como nuevas formas de entendimiento militar.

Para prevenir fraudes en esta era digital, es crucial adoptar medidas proactivas, como educación en ciberseguridad y verificación rigurosa de fuentes, especialmente ante el sofisticado uso de la inteligencia artificial en esquemas de estafa.